机构名称:

¥ 1.0

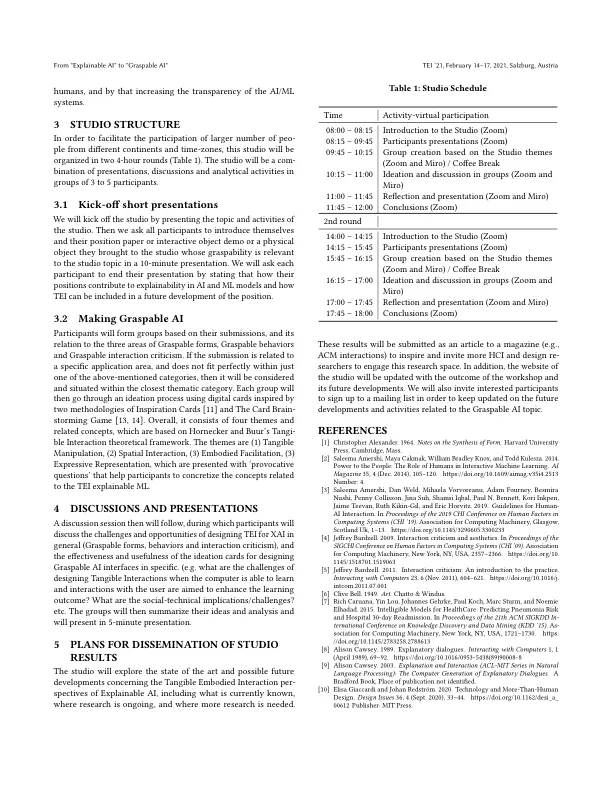

自人工智能 (AI) 和机器学习 (ML) 出现以来,研究人员一直在研究智能计算系统如何与用户及其周围环境交互和联系,从而引发了有关偏见的人工智能系统、ML 黑盒、用户信任、用户对系统的控制感知以及系统透明度等问题的争论。所有这些问题都与人类如何通过使用不同交互模式的界面与人工智能或机器学习系统交互有关。先前的研究从各种角度解决了这些问题,从通过伦理和科学技术研究 (STS) 视角理解和构建问题,到为问题找到有效的技术解决方案。但几乎所有这些努力都有一个共同的假设:如果系统能够解释其预测的方式和原因,人们就会有更好的控制感知,因此会更加信任这样的系统,甚至可以纠正它们的缺点。这个研究领域被称为可解释人工智能 (XAI)。在这个工作室中,我们总结了该领域先前的努力;然而,我们专注于使用有形和具身交互 (TEI) 作为理解 ML 的交互方式。我们注意到,物理形式及其行为的可用性不仅可以为 ML 系统的可解释性做出贡献,还可以为批评创造一个开放的环境。这个工作室旨在批评可解释的 ML 术语,并描绘 TEI 可以为 HCI 提供的机会,以设计更可持续、更易掌握和更公正的智能系统。

从“可解释的人工智能”到“可掌握的人工智能”

主要关键词